Cuando alguien ve algo que no está allí, las personas a menudo se aplican a la experiencia como alucinación. Las alucinaciones ocurren cuando su percepción sensorial no se adapta a estímulos externos.

Las tecnologías que dependen de la inteligencia artificial también pueden tener alucinaciones.

Cuando el sistema algorítmico genera información que parece creíble, pero en realidad es incorrecta o incorrecta, los científicos informáticos lo llaman y la alucinación. Los investigadores encontraron estos comportamientos en diferentes tipos de sistemas, desde chatbot, como chatggpt hasta generadores de imágenes como dalls hasta vehículos autónomos. Somos investigadores de ciencias de la información que estudiaron alucinaciones en los sistemas de reconocimiento de voz.

Donde se usan en la vida cotidiana y se utilizan sistemas, sus alucinaciones pueden representar riesgos. Algunos pueden ser más pequeños: cuando ChatBot da la respuesta incorrecta a una pregunta simple, el usuario puede terminar mal. Pero en otros casos, la estaca es mucho mayor. De las salas de audiencias en las que y el software se utiliza para tomar decisiones sobre las sanciones para usar algoritmos para determinar la idoneidad del paciente para la cobertura, y las alucinaciones pueden tener las consecuencias de eliminar la vida. Incluso pueden ser la vida, amenazante: los vehículos autónomos usan IA para descubrir obstáculos, otros vehículos y peatones.

Inventión

Las alucinaciones y sus efectos dependen del tipo de sistema de IA. Con modelos de idiomas grandes (tecnología básica y chatbot, las alucinaciones son información que suena convincente, pero que son incorrectas, marcas o irrelevantes. AI Chatbot puede crear una referencia a un artículo científico que no existe o no da un hecho histórico que simplemente es incorrecto, pero lo hace sonar creíble.

Por ejemplo, en el caso de la corte 2023. Año, un nuevo abogado en Nueva York presentó una presentación legal que escribió con la ayuda de ChatGPT. Más tarde, los jueces promedio notaron que un breve caso mencionado era que el chatggpt se compilaba. Esto podría conducir a diferentes resultados en los tribunales si las personas no pudieran detectar datos alucinados.

Con las herramientas de IA que pueden reconocer elementos en las imágenes, las alucinaciones ocurren cuando la IA crea una inscripción que no es fiel en la imagen correcta. Imagine establecer el sistema para enumerar objetos en una imagen que solo incluye a una mujer del pecho que habla por teléfono y recibe una respuesta que una mujer habla por teléfono mientras está sentada en el banco. Esta información incorrecta podría conducir a diferentes consecuencias en los contextos en los que la precisión es crítica.

Que causa alucinaciones

Los ingenieros se construyen y los sistemas recopilan datos de masa y los alimentan a un sistema informático que detecte formularios en los datos. El sistema desarrolla métodos para responder a preguntas o realizar tareas basadas en estos formularios.

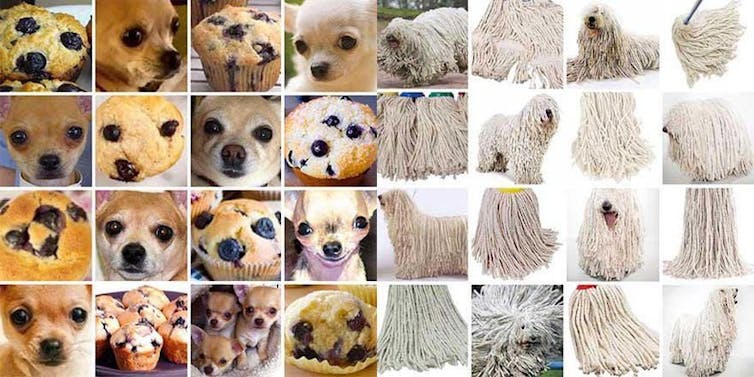

Obtenga el sistema de IA con 1,000 fotos de diferentes razas de perros, en consecuencia, y el sistema pronto aprenderá a descubrir la diferencia entre el caniche y el golden retriever. Pero alimentarle una foto de muffin para arándanos y, como demostraron que los maestros de la máquina, puede decir que el muffin chihuahua es.

El reconocimiento de objetos AIS puede tener problemas con la distinción de Chihuahuas y arándanos entre ovejas y MOPS. Shenkman et al, CC de

Cuando el sistema no entiende la pregunta o información que se presenta, puede alucitizar. Las alucinaciones a menudo ocurren cuando el modelo se encuentra en blanco basados en contextos similares con datos de capacitación o cuando se construye utilizando datos de capacitación sesgados o incompletos. Esto conduce a una especulación inexacta, como en caso de arándano incorrecto.

Es importante distinguir y alucinaciones y deliberadamente creativo y salida. Cuando se requiere que sea creativo, como escribir una historia o generar pinturas de arte, su novela es esperada y deseada. Las alucinaciones, por otro lado, ocurren cuando se les solicita y el sistema proporciona hechos o tareas especiales, pero en su lugar genera contenido incorrecto o incorrecto, al mismo tiempo es cierto.

La diferencia clave radica en el contexto y el propósito: la creatividad es adecuada para las obras de arte, mientras que las alucinaciones son problemáticas cuando se requiere la precisión y la confiabilidad.

Para abordar estos problemas, las compañías propusieron el uso de datos de capacitación de alta calidad y limitando las respuestas de IA para seguir ciertas pautas. Sin embargo, estos problemas pueden perseverar en las herramientas de IA populares.

Los modelos de idiomas grandes están alucinando de varias maneras. Lo que está en riesgo

La influencia de las salidas, como la llamada del muffin de arándanos, puede parecer trivial, pero considere diferentes tipos de tecnologías que utilizan sistemas de reconocimiento de imágenes: vehículo autónomo que identifica elementos podría conducir a un accidente de tráfico fatal. El soldado autónomo que confundió el objetivo podría vivir a civiles vivos en peligro.

Para las herramientas de IA que proporcionan reconocimiento automático de voz, las alucinaciones son transcripciones de IA que incluyen palabras o frases que nunca no habían hablado. Es más probable que esto suceda en entornos ruidosos, por el cual y el sistema puede terminar agregando palabras nuevas o irrelevantes para descifrar el ruido de fondo, como un camión que pasa o llorando a un recién nacido.

Dado que estos sistemas se integran más regularmente en la atención médica, los servicios sociales y los entornos legales, las alucinaciones en el reconocimiento automático de voz podrían conducir a resultados clínicos o legales incorrectos que dañan a los pacientes, acusaciones penales o familias que necesitan apoyo social.

Verifique el trabajo de AI

Independientemente de los esfuerzos y la compañía de mitigación de halucinación, los usuarios deben permanecer despiertos y solicitar y salir, especialmente cuando se usan en contextos que requieren precisión y precisión. Verifique la información generada por la IA con fuentes confiables, los expertos de consultoría cuando sea necesario y reconocer las limitaciones de estas herramientas son pasos esenciales para minimizar sus riesgos.

0 Comentarios